No es la primera vez que se usan módulos HBM2, sin embargo, esta vez se encuentran en una tarjeta gráfica con ranura PCIe. Esta es la nueva NVIDIA Tesla P100, y está enfocada al mercado de la computación. Sin embargo, tendremos una variante optimizada para el uso de NVLink, además de diferentes opciones de memoria para la versión anterior.

Versiones de NVIDIA Tesla P100

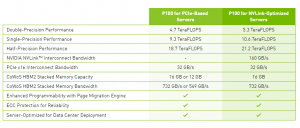

Ya hemos dicho que una de ellas está enfocada al uso de PCIe y otra al de NVLink. Esta última es la versión más potente de las 3 variantes. Nos encontramos con una potencia computacional de 21,2 TFLOPS en FP16 y 10,6 TFLOPS en FP 32. Además de sus 16 GB de memoria HBM2, con un ancho de banda de 732 GB/s. Evidentemente, podrá ser usada en un puerto PCIe, pero reducirá dramáticamente su capacidad máxima.

Por su parte, la variante enfocada al uso de PCIe de NVIDIA Tesla P100, cuanta con dos modelos. Estos se diferencian en su memoria, el mayor de este tendrá 16 GB de VRAM HBM2, mientras que el menor contará con 12 GB. Su ancho de banda es de 732 GB/s y 549 GB/s respectivamente.

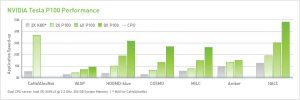

En FP16 estas últimas variables ofrecen 18,7 TFLOPS, estando esta por detrás de su hermana mayor. Se debe principalmente a las limitaciones ya conocidas de la interfaz PCIe, por lo tanto, lo más lógico para el uso de estas tarjetas es el uso de NVLink. No olvidemos que su uso óptimo es el de computación y servidores.

Respuesta de AMD

Se espera que con la llegada de Radeon RX Vega el equipo rojo introduzca la memoria HBM2 en su gama de gráficas para usuarios. Evidentemente, la hoy presentada por NVIDIA no pretende competir contra las anteriores. Sin embargo, sitúa a NVIDIA un paso por delante en el uso de estas memorias, y cabe esperar una respuesta en la gama Radeon PRO de AMD.